随着互联网的发展,SEO优化已经成为提高网站流量、增强网站竞争力的关键手段之一。

在这个信息化社会中,数据采集工作发挥着重要作用。

尤其在网站SEO中,如何进行数据采集并应用于SEO策略中,成为了众多站长和SEO从业者的关注焦点。

本文将详细介绍采集网站SEO及其在网站资料采集中的应用。

SEO即搜索引擎优化,通过优化网站结构、内容以及外部链接等,提高网站在搜索引擎中的排名,从而提高网站的曝光率和访问量。

SEO包括站内优化和站外优化两部分。

站内优化主要包括网站内容优化、页面结构优化等;站外优化主要包括外部链接建设、社交媒体推广等。

在数据采集的支撑下,可以更有效地进行SEO优化工作。

网站资料采集是SEO工作中的重要环节。

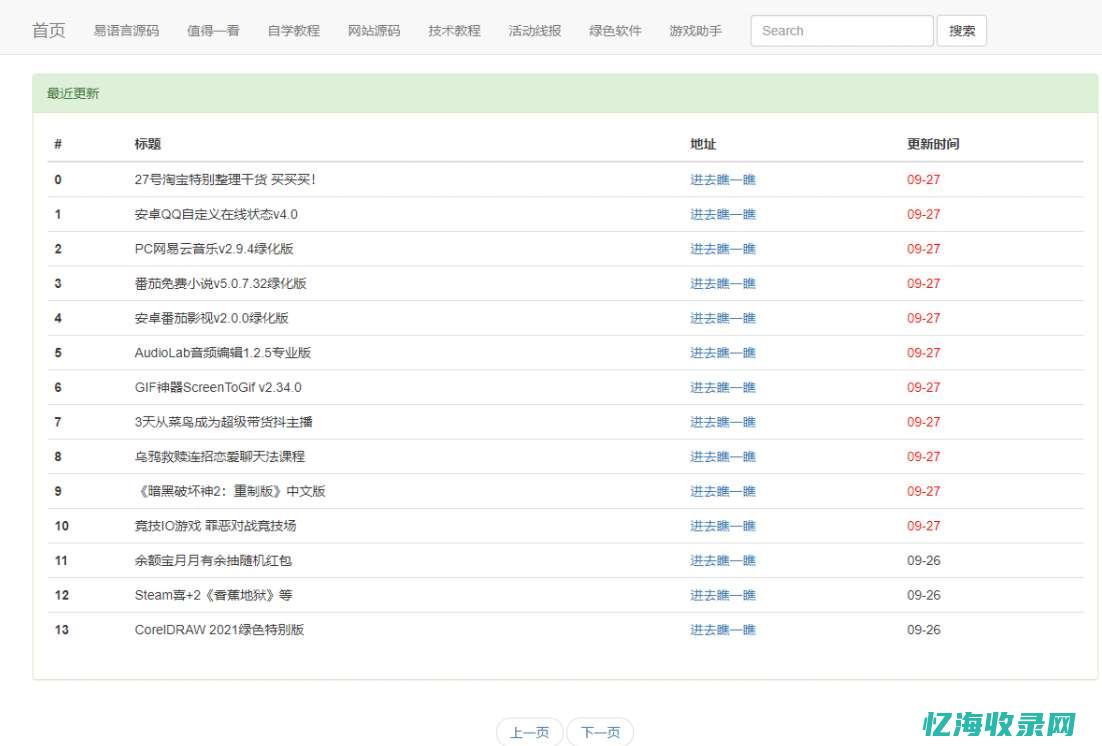

通过采集网站数据,可以了解网站的运营状况、用户需求、竞争对手动态等,从而为优化策略提供数据支撑。

采集的网站资料包括网站内容、用户行为数据、链接数据等,这些数据可以为SEO提供宝贵的信息资源。

网站资料采集可以帮助我们了解:

1. 用户需求和喜好:通过采集用户行为数据,了解用户在网站上的浏览习惯、点击行为等,从而优化内容以满足用户需求。

2. 网站性能:采集网站数据可以分析网站的访问速度、页面结构等,提高网站的易用性和用户体验。

3. 竞争对手情况:采集竞争对手的网站数据,了解竞争对手的关键词布局、内容策略等,有助于制定针对性的优化策略。

1. 关键词研究与分析:通过采集网站数据和竞争对手数据,分析关键词的搜索量、竞争程度等,确定网站的关键词布局。关键词的选择对于SEO至关重要,合理的关键词布局有助于提高网站的曝光率。

2. 内容优化:根据采集的用户需求数据,优化网站内容,提高内容的质量和吸引力。优质的内容是吸引用户的关键,同时也能提高网站在搜索引擎中的排名。

3. 链接建设:通过采集外部链接数据,了解网站的外部链接状况,进行有针对性的链接建设。外部链接是提高网站权重和排名的重要因素之一。

4. 网站结构优化:根据采集的网站数据,分析网站的页面结构、布局等,优化网站结构以提高用户体验和搜索引擎友好度。合理的网站结构有助于搜索引擎抓取和索引网页。

5. 数据分析与优化迭代:通过持续采集网站数据,分析SEO策略的效果,及时调整优化策略。数据分析是SEO工作中的重要环节,通过数据分析可以找到问题并制定针对性的解决方案。

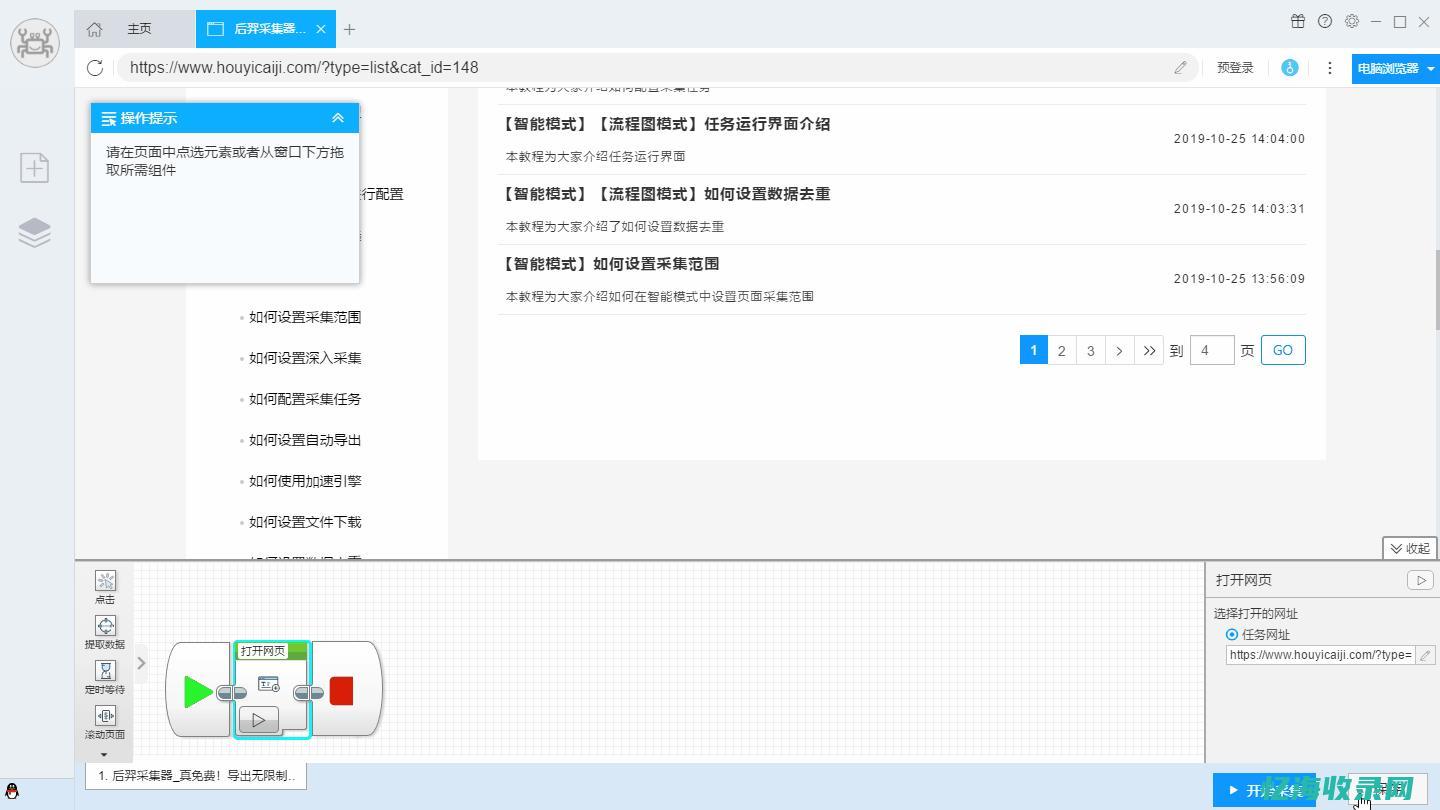

在进行网站资料采集时,需要掌握一些常用的方法与技术。

常见的网站资料采集方法包括爬虫技术、API接口调用等。

其中,爬虫技术是最常用的方法之一,通过模拟浏览器行为获取网页数据。

还可以利用API接口获取更多实时、准确的数据。

在采集过程中,需要注意遵守相关法律法规和道德准则,确保数据的合法性和隐私保护。

采集网站SEO策略在提升网站流量和竞争力方面发挥着重要作用。

通过网站资料采集,可以了解用户需求、网站性能和竞争对手情况,为SEO策略提供数据支撑。

在采集过程中,需要掌握常用的方法与技术,并遵守相关法律法规和道德准则。

将采集的数据应用于关键词研究与分析、内容优化、链接建设等方面,可以提高网站的曝光率和排名。

未来随着技术的发展和用户需求的变化,采集网站SEO策略将不断完善和优化,为网站发展带来更多机遇和挑战。

本文地址: https://yihaiquanyi.com/article/59732.html

上一篇:seo收录是什么意思seo网站收录...