随着互联网的发展,网站数据成为了重要的信息资源。

如何有效地采集这些数据,对于学术研究、市场竞争策略、个人决策等方面都具有重要意义。

本文将详细介绍采集网站数据的方法与策略,帮助读者更好地获取所需信息。

网站数据涵盖了各类信息,包括但不限于行业动态、市场趋势、竞争对手分析、用户需求等。

这些数据不仅可以帮助企业了解市场情况,调整战略方向,还可以为学术研究提供丰富的素材。

个人在日常决策中,也可以借助网站数据来辅助判断。

因此,掌握采集网站数据的方法与策略至关重要。

爬虫技术是最常见的网站数据采集方法之一。

通过模拟浏览器行为,自动抓取网页数据并解析成结构化信息。

使用爬虫技术时,需要注意遵守网站的爬虫协议,避免对网站造成不必要的负担。

同时,要合理设置爬取频率,确保数据的准确性和完整性。

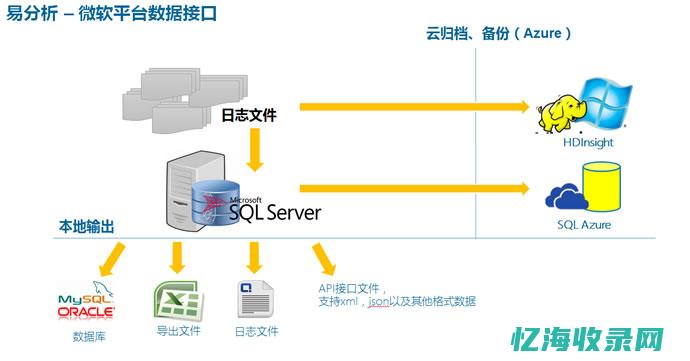

许多网站提供了API接口,通过调用这些接口可以直接获取网站数据。

这种方式效率高、稳定性好,但需要了解API的使用方法和规则。

同时,部分网站可能需要授权才能访问其API接口。

除了直接采集网站数据,还可以通过第三方数据平台获取。

这些平台通常会整合多个数据源,提供更为全面和丰富的数据。

使用第三方数据平台时,需要注意数据的准确性和实时性。

在采集网站数据前,首先要明确目标数据源。

确定数据源时,要考虑数据的真实性、实时性和完整性。

同时,要关注数据来源的合法性,遵守相关法律法规。

根据目标数据源的特点,选择合适的采集方法。

对于结构化的数据,可以采用爬虫技术或API接口获取;对于非结构化的数据,可以考虑人工采集或第三方数据平台。

在采集网站数据时,要制定合理的采集计划。

包括数据采集的时间、频率、范围等。

合理的采集计划可以提高数据的质量和效率。

采集到的数据可能包含噪声和冗余信息,需要进行清洗和整理。

数据清洗包括去除重复数据、处理缺失值、纠正错误数据等。

整理数据时,要根据需求对数据进行分类和结构化处理,以便于后续分析和使用。

在采集网站数据时,要遵守相关法律法规,尊重网站的数据使用协议和隐私政策。

避免非法获取和使用数据,以免引起法律纠纷。

部分网站会采取反爬策略,如设置反爬虫机制、限制访问频率等。

在采集数据时,要注意这些策略,合理规避,确保数据的顺利获取。

在采集网站数据时,既要保证数据的质量,又要关注数据采集的效率。

合理平衡两者关系,提高数据采集的整体效果。

本文详细介绍了采集网站数据的方法与策略,包括网站数据的重要性、采集方法、采集策略以及注意事项。

希望读者能够掌握这些方法与策略,更好地获取和分析网站数据,为学术研究、市场竞争策略、个人决策等方面提供有力支持。

本文地址: https://yihaiquanyi.com/article/59777.html

上一篇:河南优化营商环境河南优化营商环境实施意见...