随着人工智能和大数据技术的飞速发展,机器学习算法的应用越来越广泛。

在高性能计算领域,GPU(图形处理器)服务器凭借其强大的并行处理能力,为机器学习提供了巨大的性能优势。

本文将深入探讨GPU服务器在机器学习领域的性能表现,同时为大家介绍GPU服务器的使用教程。

GPU服务器是一种配备高性能图形处理器的服务器,其GPU主要用于通用计算。

与传统的CPU相比,GPU拥有更多的核心,更适合处理大规模并行计算任务。

在机器学习领域,GPU服务器可以加速模型的训练和推理过程,提高计算效率。

1. 加速模型训练:机器学习模型的训练通常需要大量的数据运算,GPU服务器的并行处理能力可以显著提高模型训练的速度。

2. 提高计算效率:对于复杂的机器学习算法,GPU服务器可以在更短的时间内完成计算任务,从而提高研发效率。

3. 支持大规模数据集:GPU服务器可以处理大规模的数据集,为深度学习和大数据处理提供强大的支持。

4. 实时性要求高:在语音识别、自动驾驶等领域,GPU服务器的实时处理能力可以满足高时效性的需求。

1. 选择合适的GPU服务器:根据实际需求选择合适的GPU服务器,考虑因素包括GPU型号、内存大小、计算能力等。

2. 安装必要的软件:在GPU服务器上安装操作系统、深度学习框架(如TensorFlow、PyTorch)和CUDA(用于运行GPU的编程接口)。

3. 配置环境:配置GPU环境变量,确保系统能够充分利用GPU资源。

4. 模型训练与推理:使用深度学习框架在GPU服务器上加载模型,进行模型的训练和推理。

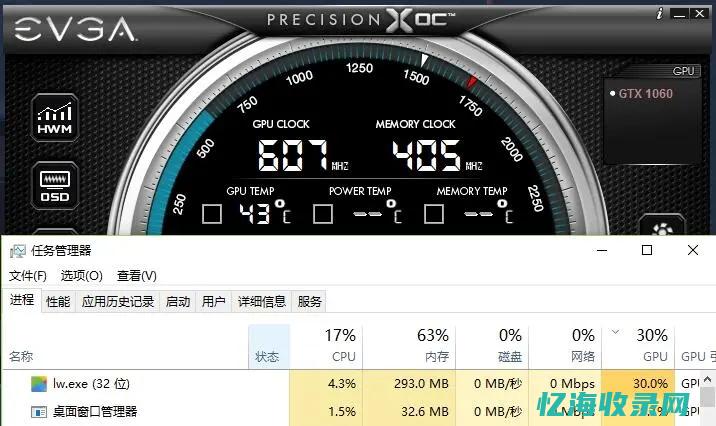

5. 监控与管理:使用监控工具对GPU服务器的运行状态进行实时监控和管理,确保服务器的稳定运行。

1. 选择合适的深度学习框架:不同的深度学习框架对GPU的支持程度不同,选择合适的框架可以提高性能。

2. 优化代码:对代码进行优化,减少不必要的计算和优化算法,提高计算效率。

3. 数据管理:合理管理数据,避免数据加载成为瓶颈,影响计算性能。

4. 监控和调整资源:实时监控GPU服务器的资源使用情况,合理分配和调整资源,避免资源浪费和瓶颈。

以图像识别为例,使用GPU服务器可以显著加速模型的训练过程。

在传统的CPU上,可能需要数天甚至更长时间才能完成模型的训练,而在GPU服务器上,这个过程可能只需要几个小时甚至更短。

GPU服务器还可以提高模型推理的速度,使实时图像识别成为可能。

本文介绍了GPU服务器在机器学习领域的性能优势及使用教程。

通过合理的配置和优化,GPU服务器可以显著提高机器学习任务的计算效率和性能。

随着人工智能技术的不断发展,GPU服务器将在更多领域得到广泛应用。

希望本文能对大家了解和使用GPU服务器有所帮助。

未来,随着技术的不断进步,GPU服务器的性能将进一步提高。

更多的优化技术和算法将不断涌现,为机器学习领域带来更多的可能性。

同时,随着云计算和边缘计算的普及,GPU服务器将在更多场景得到应用。

我们期待GPU服务器在未来为人工智能领域的发展带来更多的惊喜和突破。

本文地址: https://yihaiquanyi.com/article/98c2902f3a9242d4932a.html

上一篇:掌握GPU服务器决胜未来高负载计算的必备武...